対話型AIツールは当初、外部情報へのアクセスが一切できませんでしたが、後に検索機能などの外部ツールが徐々に追加されるようになりました。しかし、「検索」という機能は範囲が広く、天気予報や株価照会といった特定の機能に対しては、ネット検索でも実現可能ですが、やはり直接APIを統合して天気や株式市場の機能を追加する方が効率的です。

振り返ってみると、インターネット上のサービスは数え切れないほど存在し、全てをAPIで接続することは不可能です。さらに、一部のツールはHTTP APIの形式ではなく、ローカルコンピューター上でのみ利用可能なツールです。例えば、プログラミングの際、エディターがブラウザの正確な画面、構造、開発者デバッグ情報にアクセスできることが望ましいですが、これらはHTTP APIの形式では接続できません。

MCPは、AIがツールの使用方法を理解するためのオープン標準です。例えば、タスク管理を支援してもらいたい場合、AsanaのMCPを使用してAPI経由でタスク管理サービスに接続すれば、プロジェクト全体の計画、必要なデータの作成、さらにはタスクの依存関係の管理などを支援してもらえます。

先ほど例に挙げた開発支援のためのブラウザ操作も、mcp-playwrightを使用することで、ブラウザを操作し、コンソールを直接読み取ってエラーを判断し、自動修正することが可能です。

ちょうど仕事で関連するタスクがあり、関連事項を調査する必要があったため、ProtocolinkとMoralisを使用してUniswapのMCPを作成し、Claude Desktop内で直接取引できるようにしました。

デモはこちらのYouTubeリンクでご覧いただけます。

完成後、ここ10年のメッセージングアプリの発展について考えさせられました。最初期はLINE MINI AppとTelegram Mini Appsが普及し始めましたが、後に大部分の機能は外部Webページで実装され、ごく一部の簡易UIのみがメッセージング会話内に埋め込まれるようになりました。私も同じアプローチを取るでしょう。結局、外部サイトでの実装の方が簡単で、最も必要なユーザー認証部分だけをLINE内で処理すれば良いのですから。

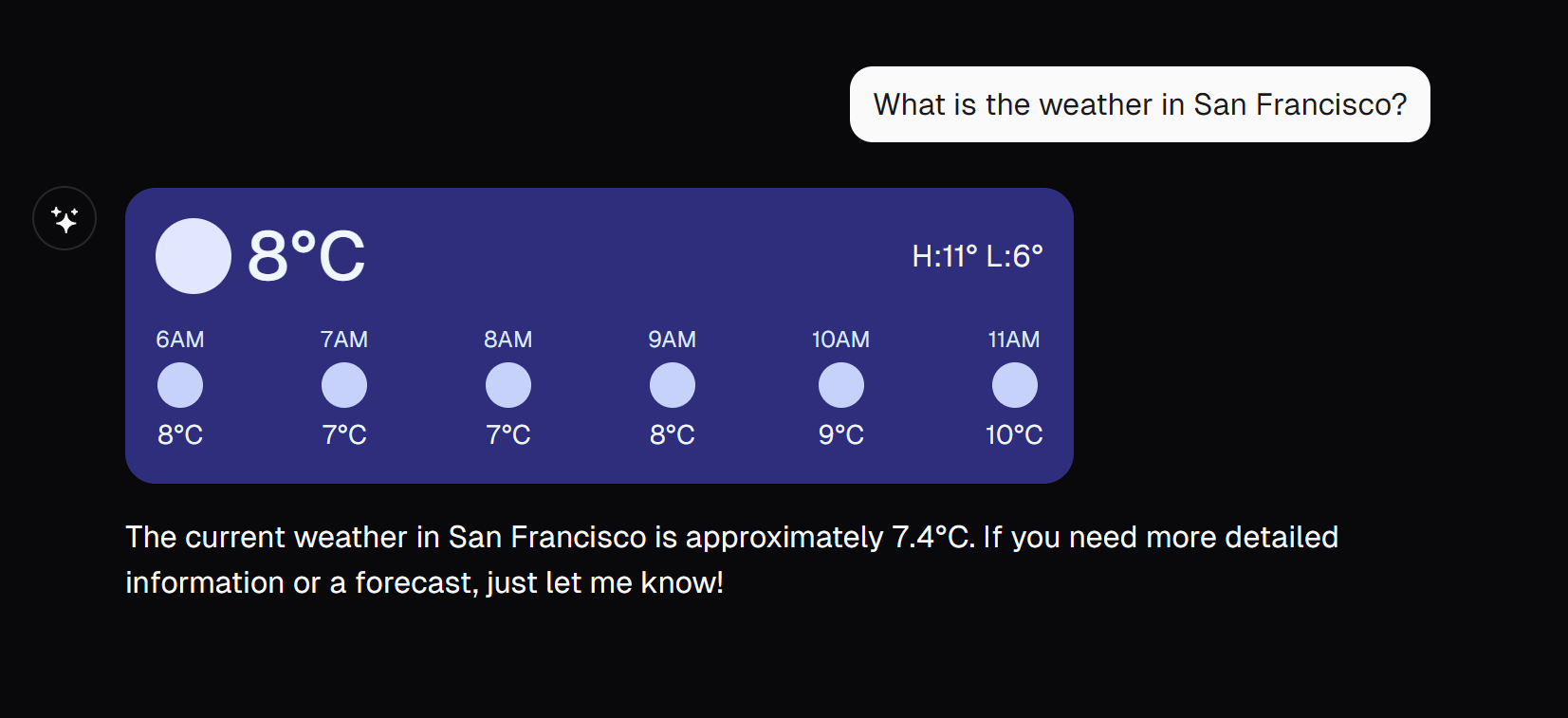

数か月前、VercelのAI SDK 3.0を見た時、将来のソフトウェアユーザーインターフェースが大きく変わる可能性があることを実感しました。その発表には、天気を尋ねた後、直接天気表示インターフェースを生成できるツールが含まれていました。

最初は完全に動的なUI生成だと思いましたが、ドキュメントを詳しく読むと、実際にはUIを事前定義する必要があることが分かりました。

まだそこまで実現していないとしても、ある想像の余地が開かれました。将来、UIコンポーネントが受信データのコンテキストに基づいて動的に適切なUIインターフェースを組み立てられるようになったら、どのような体験になるでしょうか?今後のユーザーインタラクションが現在とまったく異なるものになったら?音声対話の後、完全に動的に適切なユーザーインターフェースが生成されるようになるのでしょうか?

私たちの業界では、どのような影響が生じるのでしょうか?

未来を投影したり想像したりすることは興味深いことだと思います。未来は混沌としていながらも面白そうですが、面白い要素の方が多くあってほしいと願っています。

あとがき

このuniswap-mcpは研究目的のためだけに作成されたもので、コードの99%は全てCursorによって書かれました。私たちは皆、環境変数を通じて秘密鍵をプログラムに渡すべきではないことを知っていますが、それでも興味がある方のために、以下にソースコードを公開します。テストと研究目的でのみご使用ください。また、多額の資金を入れないようにしてください。